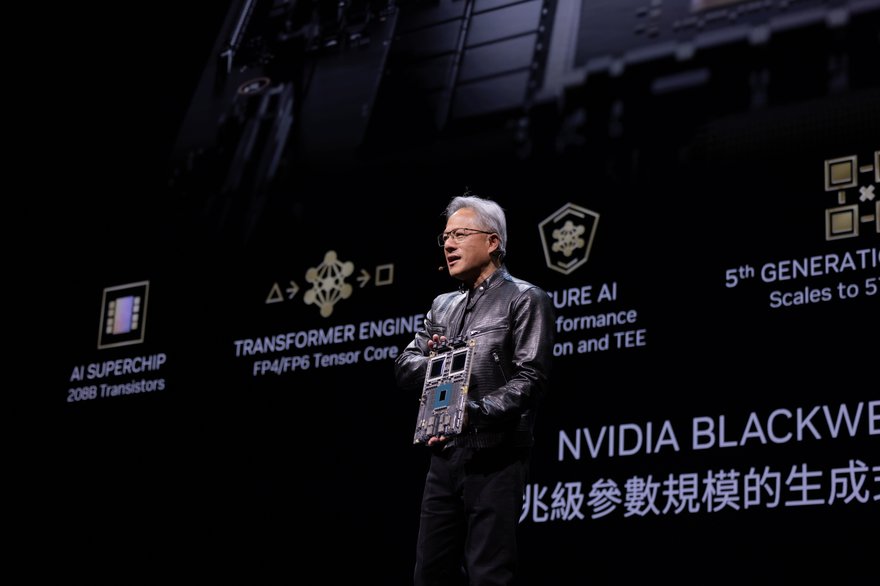

El director ejecutivo de Nvidia, Jensen Huang, aprovechó su discurso de apertura en Computex en Taiwán para revelar la próxima hoja de ruta de semiconductores de la compañía, en la que se lanzará una nueva familia de productos cada año.

También anunció que el sucesor de la arquitectura de chip Blackwell de Nvidia se llama Rubin y estará disponible a partir de 2026.

Si bien se proporcionaron muy pocos detalles técnicos sobre los chips, Huang reveló que la cartera de Rubin incluirá nuevas GPU, una nueva CPU basada en Arm llamada Vera y chips de red avanzados que contienen el conmutador convergente InfiniBand/Ethernet X1600.

“Nuestra empresa tiene un ritmo de un año. Nuestra filosofía básica es muy simple: construir toda la escala del centro de datos, desagregar y venderle piezas en un ritmo de un año y llevar todo a los límites de la tecnología”, explicó Huang durante su discurso de apertura.

Además de aumentar su ciclo de lanzamiento de GPU de cada dos años a anualmente, Huang también anunció que Nvidia aceleraría su calendario de lanzamiento de productos de red, y la compañía está planeando lanzar nuevos productos Spectrum-X cada año.

Spectrum-X, que debutó en mayo de 2023, es una plataforma de red acelerada para cargas de trabajo de IA generativa y Nvidia afirmó que es la primera oferta de Ethernet diseñada específicamente para IA. La compañía afirma que acelera el rendimiento de la red de IA generativa en 1,6 veces con respecto a las estructuras Ethernet tradicionales.

En un comunicado, Nvidia dijo que cada nueva versión ofrecería "mayor ancho de banda y puertos", además de "conjuntos de funciones de software y programabilidad mejorados para mejorar el rendimiento de la red Ethernet de IA."

"La IA generativa está remodelando las industrias y abriendo nuevas oportunidades para la innovación y el crecimiento", dijo Huang a los asistentes al evento. "Hoy estamos en la cúspide de un cambio importante en la informática... la intersección de la IA y la informática acelerada redefinirá el futuro".

Fábricas de IA y computación acelerada

En otra parte de su discurso de dos horas de duración, Huang reveló que empresas como Asus, Ingrasys, Inventec, QCT, Supermicro y Wiwynn se estaban asociando con Nvidia para ofrecer lo que él llamó fábricas de IA.

Impulsadas por la arquitectura Blackwell de la compañía, estas denominadas fábricas consisten en sistemas de Inteligencia Artificial para aplicaciones en la nube, locales, integradas y de Edge, con ofertas que van desde GPU únicas hasta múltiples, procesadores basados en x86 o Grace y procesadores aéreos a la tecnología de refrigeración líquida.

Huang también aprovechó su discurso para lanzar la nueva plataforma GB200 NVL2 para Nvidia MGX. Diseñada para llevar capacidades de IA generativa al centro de datos y que consta de dos GPU Blackwell y dos GPU Grace, la plataforma ofrecerá 40 petaflops de rendimiento de IA en 144 núcleos de CPU Arm Neoverse y 1,3 terabytes de memoria.

Nvidia dijo que la plataforma ofrece un "rendimiento incomparable", proporcionando inferencia LLM 5 veces más rápida, búsqueda de bases de datos vectoriales 9 veces más rápida y procesamiento de datos 18 veces más rápido en comparación con las ofertas tradicionales de CPU y GPU.

“La próxima revolución industrial ha comenzado. Las empresas y los países se están asociando con NVIDIA para cambiar los centros de datos tradicionales de miles de millones de dólares a la computación acelerada y construir un nuevo tipo de centro de datos (fábricas de IA) para producir un nuevo producto: la inteligencia artificial”, dijo Huang. "Desde los fabricantes de servidores, redes e infraestructura hasta los desarrolladores de software, toda la industria se está preparando para que Blackwell acelere la innovación impulsada por la IA en todos los campos".