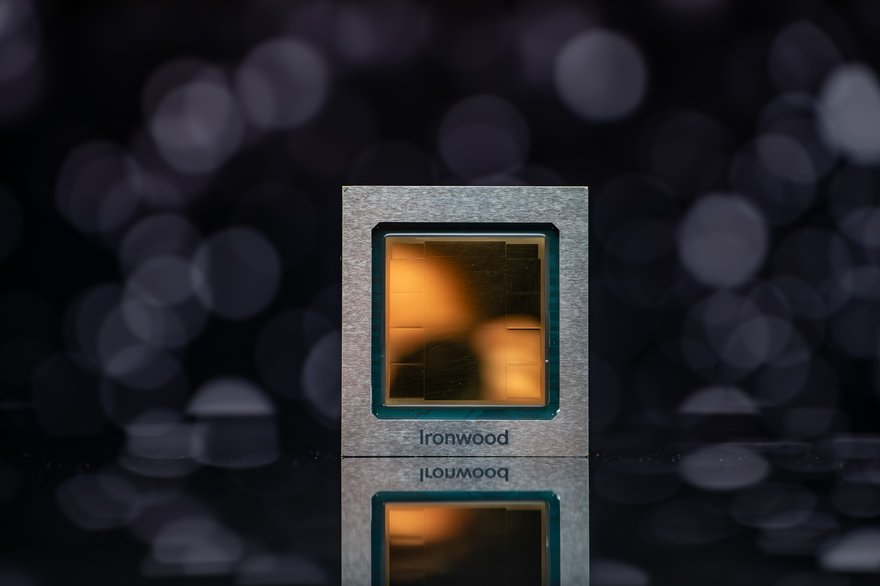

Google ha presentado su unidad de procesamiento tensor (TPU) de séptima generación, Ironwood.

Anunciado en el evento Next '25 de la compañía en Las Vegas, Google ha dicho que es la primera TPU diseñada específicamente para inferencias.

Diseñado para soportar los requisitos computacionales de lo que Google denominó "la próxima fase de la IA generativa", Ironwood viene en dos tamaños refrigerados por líquido según las demandas de carga de trabajo de la IA: una configuración de 256 chips y una configuración de 9216 chips.

Google ha dicho que cada chip individual posee un pico de procesamiento de 4,614 teraflops y, cuando se escala a 9,216 chips, cada pod totaliza 42,5 exaflops, lo que, según la compañía, es más de 24 veces la potencia computacional de la supercomputadora más poderosa del mundo, El Capitan, que ofrece 1,742 exaflops por pod.

Sin embargo, el rendimiento de El Capitan se mide en precisión FP64, y parece que Google ha utilizado la evaluación comparativa de precisión FP8, o cálculos de precisión de 8 bits, para calcular el rendimiento computacional de Ironwood.

El rendimiento de la IA se mide en FP8, pero el rendimiento computacional tradicional se mide en cálculos de doble precisión, también conocidos como FP64, el estándar de la industria para sistemas grandes.

Como resultado, un sistema que alcanza los 100 petaflops de rendimiento FP64 es más potente que un sistema que ha alcanzado los 100 petaflops de rendimiento FP8, por ejemplo.

DCD se ha puesto en contacto con Google para solicitar una aclaración.

Ironwood también ofrece 192 GB de memoria de alto ancho de banda (HBM) de 7,4 Tbps por chip, un aumento de 6 veces con respecto a la TPU Trillium de sexta generación de Google, además de un ancho de banda de interconexión entre chips (ICI) bidireccional de 1,2 Tbps, una mejora de 1,5 veces con respecto a Trillium.

En una conferencia de prensa antes del lanzamiento, Amin Vahdat, vicepresidente y gerente general de sistemas ML y nube, dijo que Ironwood es casi 30 veces más eficiente energéticamente que la primera TPU en la nube de 2018 y casi el doble de eficiente que Trillium.

"Nos entusiasma presentar nuestra TPU de séptima generación, Ironwood", afirmó Vahdat. "Está diseñada desde cero para la inferencia a escala, lo que lleva a nuestros clientes a la era de la inferencia, donde ya no se trata de los bits de datos del modelo, sino de lo que el modelo puede hacer con los datos una vez entrenado".

Además, con el lanzamiento de Ironwood, Google ha dicho que también está impulsando su red a "nuevas alturas", con su nuevo 400G Cloud Interconnect y Cross-Cloud Interconnect que ofrece hasta 4 veces más ancho de banda que el 100G Cloud Interconnect y Cross-Cloud Interconnect de la compañía.

Además, Google ha afirmado que su oferta de almacenamiento en bloque de red Hyperdisk Exapool permite a los usuarios aprovisionar hasta un exabyte de capacidad de almacenamiento en bloque, el mayor rendimiento y capacidad por clúster de IA de cualquier hiperescala, mientras que un nuevo depósito zonal de Cloud Storage proporciona una carga de datos de lectura aleatoria hasta 20 veces más rápida que un depósito regional de Cloud Storage, lo que permite a los usuarios colocar su almacenamiento principal con TPU o GPU.

“Hace más de una década, Google comenzó a invertir en el desarrollo de TPU para nuestros propios servicios con el fin de ampliar las fronteras de lo posible en escala y eficiencia”, afirmó Vahdat. “Como industria, en los últimos ocho años, hemos visto un aumento interanual de diez veces en la demanda de modelos de capacitación y servicio, lo que representa un factor de 100 millones”.