Aunque la compañía a menudo se ha quedado atrás de empresas como Amazon y Microsoft en términos de ingresos del negocio de la nube, Google se está promocionando firmemente como el lugar donde estar cuando se trata de inversiones en infraestructura de IA.

Si bien en realidad es discutible, durante la Google Cloud Summit en Londres en octubre de 2024, Tara Brady, presidenta de Google para EMEA, afirmó que era un "hecho" que Google creó la IA generativa, probablemente refiriéndose al documento de investigación de Google de 2017 Attention Is All You Need, que introdujo el concepto de transformador que sustenta muchos de los modelos genAI actuales.

Ya sea una startup o una empresa grande, Google quiere su inversión en IA. Brady afirmó que hoy en día el 90% de los unicornios de IA utilizan GCP, y este año la compañía ha anunciado acuerdos centrados en IA con empresas como Vodafone, Warner Bros. Discovery, Mercedes-Benz, Bayer, Best Buy, Orange, PwC y otras. Pfizer, Hiscox, Toyota, Lloyds Bank, Bupa y Monzo también fueron nombrados en el escenario de Londres como clientes de IA.

"Estamos muy entusiasmados", declaró Sachin Gupta, director general de infraestructura de Google Cloud, a DCD. "Al observar la cantidad de industrias que están pasando de la experimentación al escalamiento y la producción, creo que es muy emocionante".

«La IA nos está obligando a tomar una decisión», afirma en una entrevista con DCD en la cumbre de Londres. «A diferencia de las aplicaciones tradicionales, la IA, en la mayoría de los casos, requiere una nueva inversión en infraestructura».

Hipercomputadora: aumento de la eficiencia

Google sin duda está invirtiendo. Al igual que otros hyperscalers, la compañía está construyendo rápidamente nuevas ubicaciones a nivel mundial y expandiendo sus campus existentes.

Cuando se le pregunta si el rápido desarrollo de la capacidad de IA está rompiendo la arquitectura tradicional del centro de datos de nube pública de grandes regiones atendidas por múltiples zonas de disponibilidad cercanas, Gupta señala que los enfoques pueden tener que ser diferentes para el entrenamiento y la inferencia.

“Cuando se realiza un entrenamiento a gran escala, se necesitan clústeres grandes y contiguos. Hay dos maneras de lograrlo: ubicarlos en la misma ubicación o ubicarlos lo suficientemente cerca y con suficiente ancho de banda de red para que no se conviertan en un cuello de botella”, explica. “Ambas opciones existen y, dependiendo de la ubicación y la disponibilidad, buscaremos una opción de diseño específica”.

“Para la inferencia, los clientes ven que, a medida que se atiende más a un cliente final, la confiabilidad y disponibilidad de eso, así como la latencia de esa opción, pueden cambiar la forma en que se piensa sobre los diseños”.

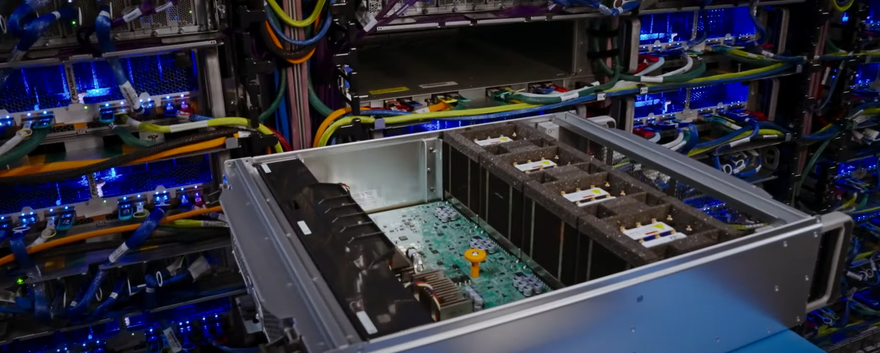

Un aspecto clave de la ambición de Google en materia de IA es su concepto de hipercomputadora. Anunciada a finales de 2023, la hipercomputadora se describe como una arquitectura unificada que combina y optimiza todos los elementos de software y hardware.

“Lo pensamos como una arquitectura de cómo construimos toda la infraestructura optimizada para IA con todos los componentes”, afirma.

Ese concepto holístico abarca desde los sistemas eléctricos y de refrigeración de los centros de datos físicos, pasando por el hardware de almacenamiento, redes y TI, hasta la pila de software que incluye diferentes servicios y equilibrio de carga.

¿Cómo obtener el máximo beneficio para los clientes de esa infraestructura de la manera más rentable? Cada uno de esos componentes es importante.

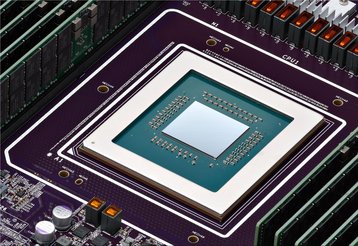

Esas ganancias combinadas, dice, significan que Google cree que puede obtener alrededor de cuatro veces el rendimiento de una GPU o TPU (los chips de IA que la compañía desarrolló internamente) en comparación con un enfoque aislado.

En una época en la que las empresas compran decenas de miles de GPU por millones de dólares y construyen clústeres a escala de gigavatios para albergarlas y alimentarlas, esta mejora es significativa.

Respecto de la actual construcción del centro de datos de la empresa, Gupta dice que el pensamiento de Google sobre la infraestructura de IA generalmente se distribuye en tres grandes grupos que consideran diferentes requisitos de latencia y soberanía.

"Si no es sensible a la latencia y no tiene requisitos soberanos, probablemente sea mejor para el cliente simplemente ubicarlo en unas pocas ubicaciones en el mundo, y puede usar cualquiera de nuestros clústeres más grandes para hacerlo", afirma.

También hay muchos países donde se puede entrenar el modelo con datos generales en cualquier lugar. Pero para que funcione o se ajuste con tus propios datos, debe estar en tu país. Para ello, analizamos qué países tienen esas necesidades y cómo instalamos GPU y TPU en el país para dar soporte a los clientes.

La tercera forma de verlo es el requisito de latencia pura, dónde necesito estar ahora, dondequiera que estén mis clientes finales. Habrá casos de uso únicos en los que necesitaré una latencia de un solo dígito en milisegundos y tendré que estar mucho más cerca del usuario final. Pero creo que los casos de uso sensibles a la latencia están en la etapa inicial.

Para los dos primeros grupos (grandes clústeres y requisitos locales), Gupta afirma que la presencia regional actual y prevista de la empresa es suficiente. Para los requisitos de baja latencia y soberanía más estrictos, la empresa busca ofrecer soluciones en la nube locales.

Llevando la IA a la nube local

La mayoría de los principales proveedores de la nube hace tiempo que dejaron de intentar convencer a las grandes empresas de que deberían trasladar todas sus cargas de trabajo a la nube.

Sin embargo, fue interesante ver en la cumbre de Google Cloud en Londres una diapositiva que afirmaba que la industria ya había "pasado el último ciclo de actualizaciones de centros de datos empresariales" y que incluso las grandes empresas ya no estaban simplemente "primero en la nube", sino que apuntaban a "solo la nube", aunque varios titulares sobre la repatriación de la nube pueden sugerir lo contrario.

Gupta es más mesurado sobre la idea de la muerte de los centros de datos empresariales.

“Para la IA, tengo que hacer algo nuevo. Pero ¿qué camino debo tomar?”, dice. “Si buscas la máxima escalabilidad, la máxima flexibilidad, las últimas innovaciones y esas economías de escala, la nube pública es el mejor lugar para hacerlo”.

Pero trabajo con muchos clientes para quienes eso simplemente no va a funcionar. Si algo los mantiene en sus instalaciones, queremos asegurarnos de que tengan la misma experiencia en la nube y puedan acceder a la IA donde la necesiten», añade.

“Defensa, gobierno federal, industrias altamente reguladas, bancos centrales, el sector energético; hay muchos casos de uso donde simplemente no están listos o no pueden aprovechar la nube pública para algunas de sus cargas de trabajo y datos”.

Google Distributed Cloud es la solución de la compañía para brindar capacidades y modelos de consumo similares a los de la nube a las ubicaciones locales o perimetrales de los clientes. Al igual que Amazon Web Services (AWS), Microsoft Azure e incluso Oracle Cloud, Google ofrece servidores y racks locales preconfigurados y administrados que los clientes pueden instalar en sus propios centros de datos o en otras ubicaciones perimetrales, y que ofrecen acceso a los servicios de Google Cloud.

Utiliza hardware de terceros como HPE o Dell en lugar de sus propios servidores propietarios.

La versión conectada del servicio comienza con un servidor 1U, escalable a cientos de racks. La versión con aislamiento de aire comienza como un pequeño dispositivo y también escala a cientos de racks.

Un cliente destacado es McDonald's, que está implementando hardware de Google Distributed Cloud en miles de sus tiendas en todo el mundo para analizar los equipos. Varias empresas utilizan el servicio para ofrecer su propia nube soberana a sus clientes.

Para los clientes que desean capacidades de IA en las instalaciones, pero desean una experiencia similar a la de la nube (y un modelo de costos) sin la necesidad de invertir en GPU, las ofertas de nube en las instalaciones de los hyperscalers podrían ser una opción viable, que potencialmente ofrece una latencia y costos más bajos.

Los casos de uso basados en IA que Google está viendo para clientes locales incluyen ejecución de traducción, modelos de voz a texto, capacidades de búsqueda empresarial e inferencia local.

“A veces escuchamos que los clientes aceptan entrenar su modelo en la nube pública, pero luego quieren implementarlo localmente, perfeccionarlo y crear su propio agente o cualquier aplicación que estén intentando desarrollar”, afirma Gupta.

La modernización de aplicaciones (refactorizar y actualizar las aplicaciones empresariales existentes mientras se intentan desarrollar nuevas capacidades de IA) es otro factor impulsor de este tipo de implementaciones locales.

“Además de esa aplicación o agente de IA, todavía hay una gran cantidad de aplicaciones y datos empresariales en diversas ubicaciones, muchos de ellos en máquinas virtuales, alojados localmente”, afirma Gupta. “A medida que las empresas analizan la decisión de invertir en IA, ¿cuánto del resto de ese patrimonio también se destina a un nuevo modelo de nube? Esto puede ayudarles a migrar esos entornos locales a otro entorno local que sea un entorno de nube con API en la nube”.

Por ahora, Gupta dice que la oferta de nube distribuida solo proporciona GPU Nvidia; los clientes actualmente no pueden acceder a las TPU de alta gama de Google fuera de los centros de datos de Google, aunque ofrece una versión mini conocida como Edge TPU en una placa de desarrollo a través de su subsidiaria Coral.

Google no es el único; ni Microsoft ni Amazon ofrecen su silicio personalizado como parte de sus servicios locales. Al preguntársele si las TPU de Google podrían llegar alguna vez a las instalaciones de los clientes a través de su Nube Distribuida, Gupta afirma que la compañía está abierta a la idea.

¿Podríamos adaptarlo a AMD o Intel, o a nuestros propios servidores con TPU? Sí. Pero por ahora, para los casos de uso que estamos viendo, creemos que los tenemos cubiertos con los procesadores A100 y H100 de Nvidia, y también buscaremos compatibilidad con H200.

Y añade: "Seguiremos estudiando ese mercado y, si necesitamos ofrecer soporte para hardware diferente, por supuesto, evolucionaremos".

Soberanía: ¿el verdadero motor de la inversión en IA?

Google, al igual que sus pares en el ámbito de la nube pública, está invirtiendo fuertemente en mercados existentes como el Reino Unido, donde la compañía anunció un nuevo centro de datos de 1.000 millones de dólares a principios de este año.

En medio de una importante escasez de capacidad en muchos mercados consolidados, especialmente en Europa, DCD pregunta si la soberanía impulsó en parte a la empresa a invertir en nuevas instalaciones centradas en IA en estos mercados tan complejos. Gupta afirma que es totalmente cierto.

“Varía según el caso de uso, lo que se necesita implementar”, dice. “La cantidad y el tipo de infraestructura que se implementa realmente dependen de los casos de uso que se intentan atender en el país.

Hay clientes que tienen requisitos de soberanía que exigen que los datos permanezcan en el país. Deben realizar inferencias en el país. Por lo tanto, debemos analizar cómo ampliamos y expandimos nuestra infraestructura para respaldarlo.

Al describir esto como un "continuo de soberanía", continúa: "Construimos centros de datos de todo tipo, de todos los tamaños, e instalamos la infraestructura adecuada según las necesidades del mercado; pueden ser TPU, GPU o CPU".

Después de ser el lugar donde comenzó genAI y ver a sus competidores apoderarse de gran parte del mercado, Google ahora espera que este continuo finalmente le permita convertirse en el hogar de la IA.