Depois de quase uma semana entre as luzes piscando e o ruído de fundo constante de máquinas de frutas e batatas fritas tilintando juntas que compõem Las Vegas, finalmente há tempo para refletir sobre a conferência AWS re:Invent 2024.

Sem surpresa, o tema abrangente do re:Invent foi a inteligência artificial (IA) - uma constante em conferências de tecnologia nos últimos dois anos.

Apesar disso, havia uma sensação de algo um pouco diferente. Algo novo estava no ar, ou talvez apenas uma mudança de sentimento. Parece que a IA deixou de ser uma bolha de emoção e se tornou uma realidade prática e tangível.

O que é interessante é como a Amazon Web Services está lidando com isso.

O Re:Invent viu muitos lançamentos de tecnologia que tiveram o público principal fazendo "ooh" e "aah" - por exemplo, o lançamento dos novos modelos da fundação Nova, ou a expansão do Amazon Bedrock Marketplace para mais de 100 modelos de IA, ou as novas ofertas do Amazon Q, ou... A lista continua.

Mas o que nos deixa empolgados na DCD, e presumivelmente também você, leitor, é o hardware e a infraestrutura que permitem tudo isso.

No início de 2024, a DCD se aprofundou na questão: a AWS pode atingir suas metas de sustentabilidade e vencer a corrida da IA? Ficou bem claro no re:Invent que essa era uma questão não apenas na mente da população em geral e da equipe editorial da DCD, mas também dos executivos da AWS.

A empresa de nuvem revelou seus números de Eficácia no Uso de Energia (PUE) pela primeira vez durante a conferência, ostentando uma média de 1,15 em seu portfólio global de data centers, com seu site de melhor desempenho registrando um PUE de 1,04.

Para comparação, o Google afirma que suas instalações têm uma média de PUE de cerca de 1,1, com seu melhor site oferecendo 1,06. As instalações da Meta, em média, oferecem um PUE de cerca de 1,08. As instalações mais recentes da Microsoft atingem um PUE de cerca de 1,12, com uma média global de instalações de 1,18 em todo o portfólio. A Oracle disse que seus data centers oferecem um PUE "tão baixo quanto" 1,15.

Não está claro por que a AWS demorou tanto para compartilhar esses dados, e a empresa não estava disposta a compartilhar mais detalhes, como qual era a "pior" pontuação do data center em termos de PUE, mas provavelmente parte disso foi para demonstrar o impacto de seus componentes de data center recém-lançados.

De acordo com a AWS, esses componentes de data center - também lançados durante o re:Invent - reduzirão a PUE média para 1,08, além de se adequarem melhor às instalações para lidar com cargas de trabalho de IA.

Os componentes incluem, mas não estão limitados a, uma solução de resfriamento líquido "nova" que permite a integração perfeita de resfriamento direto ao chip e resfriamento a ar, algo que a AWS afirma que reduzirá o número de conversões elétricas no data center em 20% e "inovações de engenharia" que permitirão que a gigante da nuvem suporte um aumento de 6x na densidade de energia do rack nos próximos dois anos. e mais 3x no futuro.

A AWS também usou dados e IA generativa para encontrar a maneira mais eficiente de posicionar racks em seu datacenter, reduzindo assim a energia ociosa e aumentando a capacidade computacional em 12% por site.

"É um ponto de dados interessante", disse Margaret O'Toole, líder mundial de tecnologia de sustentabilidade da AWS, à DCD. "Quando olhamos para uma jornada de descarbonização, procuramos dissociar o crescimento dos negócios do impacto ambiental, então estatísticas como essa são um progresso nessa direção. Ser capaz de acomodar mais cargas de trabalho de clientes por data center significa que precisamos de data centers em um ritmo mais lento".

No início de 2024, a Amazon como um todo se gabou de estar alimentando suas operações com energia 100% renovável a partir de 2023, incluindo seus data centers. De acordo com O'Toole, o aumento das necessidades de IA e energia associadas a isso levou a Amazon a incluir a energia nuclear em seu portfólio geral de energia.

Enquanto a Amazon relata atingir essa meta de 100% de energia renovável, o grupo de pressão Amazon Employees for Climate Justice (AECJ) publicou uma pesquisa argumentando que apenas 22% dos data centers da empresa eram realmente alimentados por energias renováveis.

"A Amazon está distorcendo a verdade com este anúncio que esconde o fato de que seus data centers famintos por energia operam no coração do país do carvão, e a expansão da empresa está aumentando a demanda por mais petróleo e gás", disse um comunicado da AECJ.

"Existem duas maneiras de calcular isso, o método baseado em localização e o método baseado em mercado", disse O'Toole quando questionado sobre isso. "Não há sistemas de rede no mundo que sejam 100% renováveis para o método baseado em localização. Para fazer isso, todas as fontes de energia do sistema precisariam ser renováveis ou livres de carbono, mas os sistemas de rede são um recurso compartilhado e a energia renovável é intermitente”.

"A ideia de um método baseado no mercado é que você sabe que nenhum sistema de rede será livre de carbono da noite para o dia e é uma responsabilidade compartilhada, então vamos criar mecanismos para impulsionar o investimento".

Isso é típico dos PPAs - empresas que compram créditos de energia renovável ou financiam o desenvolvimento de projetos renováveis para compensar o uso de energia de suas operações. Os PPAs são criticados por uma das razões que O'Toole apontou - a energia renovável flutua e não cobre necessariamente a energia real usada. Por causa disso, muitos estão optando por PPAs correspondentes por hora para compensar essas flutuações. O'Toole confirmou que a AWS não está fazendo isso no momento, mas está explorando maneiras de melhorar ainda mais seus PPAs - por exemplo, investindo em projetos de energia renovável em redes "sujas", onde beneficiará a rede mais do que, por exemplo, os países nórdicos, onde as fontes de energia limpa já fornecem a maior parte da energia.

Outros esforços para melhorar a sustentabilidade das operações da AWS incluem a extensão da vida útil do servidor de cinco para seis anos e o uso dos hubs de logística reversa re:Cycle da Amazon para reparar, recircular ou vender equipamentos para reutilização.

Além dos esforços para tornar os datacenters da AWS mais sustentáveis e aumentar a eficiência para lidar com a IA, a conferência re:Invent viu algumas atualizações importantes em suas ofertas do EC2 especificamente dedicadas a cargas de trabalho de IA.

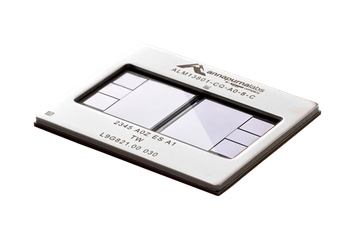

Três novas instâncias foram introduzidas pelo CEO Matt Garman: as instâncias P6 com GPUs Blackwell da Nvidia e instâncias Trn2 com o chip Trainium2 desenvolvido pela Amazon.

As instâncias Trn2, agora disponíveis ao público em geral, oferecem desempenho 30 a 40% melhor do que as GPUs atuais. As instâncias têm 16 chips trainium2 conectados por um NeuronLink interconectado de alta largura de banda e baixa latência e podem fornecer 20,8 petaflops de computação.

A gigante da nuvem também anunciou que estava lançando o Amazon EC2 Trn2 UltraServers - composto por quatro instâncias Trn2 e conectado a um NeuronLink, os UltraServers têm 64 chips Trainium2 e podem oferecer até 83,2 petaflops FP8 de poder de computação.

São esses "UltraServers" que são particularmente excitantes. Rahul Kulkarni, diretor de gerenciamento de projetos, computação e IA/ML da AWS, disse ao DCD: "O UltraServer basicamente significa que eu recebo uma dessas [instâncias Trn2] em um domínio totalmente coerente. Este é um anúncio marcante porque, no ano passado, vimos os tamanhos dos modelos continuarem a escalar - grandes modelos de linguagem, modelos de base - escalando para bilhões e trilhões de parâmetros... existem alguns modelos em que os clientes não querem dividir seus trabalhos de treinamento em vários servidores, e é aí que os UltraServers se tornam úteis.

"Como você tem quatro dessas instâncias totalmente coerentes e pode ser executado em um único nó, seu tempo de treinamento reduz drasticamente o tempo de resposta e você pode até obter um melhor desempenho em alguns dos modelos de base de ponta".

Notavelmente, a AWS também está trabalhando no "Projeto Rainer" com a Anthropic, que usará esses UltraServers para construir um cluster com "centenas de milhares de chips Trainium2 interconectados".

O CEO Matt Garman disse durante sua palestra: "O cluster terá cinco vezes o número de exaflops do cluster atual que a Anthropic usou para treinar seu conjunto líder de modelos quad para saúde, cinco vezes a quantidade de computação que eles usam na geração atual. Estou super animado para ver o que a equipe da Anthropic vai conseguir com esse tamanho".

Também na área dos chips foi o lançamento dos planos para o chip Trainium3, que será o primeiro chip da empresa feito usando um nó de processo de três nanômetros. Ele oferecerá 2x mais computação do que o Trainium2 e será 40% mais eficiente.

Durante a mesma palestra, também foi revelado que a AWS contava com a Apple entre seus clientes, com a Apple já usando os chips Inferentia e Graviton e explorando o uso do Trainium2 para pré-treinar seus modelos, esperando ver até 50% de melhoria na eficiência.

A mensagem abrangente do AWS re:Invent foi clara: a IA é rei e, como player dominante da nuvem pública, a AWS acha que faz isso melhor do que ninguém.

Uma coisa é certa, a gigante da nuvem diz que está trabalhando duro para se adaptar à besta sedenta de energia da IA de uma forma que permita escalar de forma sustentável, embora ainda esteja longe de ser perfeita nesse aspecto.

Ah, e por trás da popularidade do Graviton, ele realmente gostaria que as empresas usassem seus chips de IA.