Embora a empresa muitas vezes tenha ficado atrás de companhias como a Amazon e a Microsoft em termos de receitas de negócios em nuvem, o Google está se apresentando como o lugar para se estar quando se trata de investimentos em infraestrutura de IA.

Embora discutível na realidade, durante o Google Cloud Summit em Londres em outubro de 2024, Tara Brady, presidente da EMEA do Google, afirmou que era um "fato" que o Google criou IA generativa – provavelmente referindo-se ao artigo de pesquisa do Google de 2017 Atenção é tudo o que você precisa, que introduziu o conceito de transformador que sustenta muitos dos modelos genAI de hoje.

Seja uma startup ou uma empresa, o Google quer seus dólares de IA. Brady disse que hoje 90% dos unicórnios de IA usam o GCP e, este ano, a empresa anunciou acordos centrados em IA com empresas como a Vodafone, Warner Bros. Discovery, Mercedes-Benz, Bayer, Best Buy, Orange, PwC e outras. A Pfizer, Hiscox, Toyota, Lloyds Bank, Bupa e Monzo também foram nomeados no palco em Londres como clientes de IA.

"Estamos muito animados", disse o gerente geral de infraestrutura do Google Cloud, Sachin Gupta, à DCD. "Quando você olha para o número de indústrias, onde elas estão passando da experimentação para a escala e produção, acho que isso é muito, muito empolgante".

"A IA está forçando uma decisão", diz ele, falando à DCD na cúpula em Londres. "Ao contrário dos aplicativos legados e tradicionais, a IA, na maioria dos casos, requer um novo investimento em infraestrutura".

Hipercomputador – ganhos de eficiência

O Google certamente está investindo. Como seus colegas hiperescalas, a empresa está construindo rapidamente novos locais globalmente e expandindo os campi existentes.

Quando perguntado se a rápida construção da capacidade de IA está quebrando a arquitetura tradicional de data center em nuvem pública de grandes regiões atendidas por várias zonas de disponibilidade próximas, Gupta observa que as abordagens podem ter que ser diferentes para treinamento versus inferência.

"Quando você está fazendo treinamento em larga escala, você quer clusters grandes e contíguos. Existem duas maneiras de conseguir isso; você os coloca no mesmo local, ou eles estão próximos o suficiente e colocam tanta largura de banda de rede que não se torna um gargalo", diz ele. "Ambas as opções existem e, dependendo da localização e do que está disponível, buscaremos uma determinada opção de design".

"Para inferência, os clientes veem isso quanto mais você está atendendo a um cliente final e, portanto, a confiabilidade e a disponibilidade disso, a latência dessa opção, podem mudar a forma como você pensa sobre os projetos."

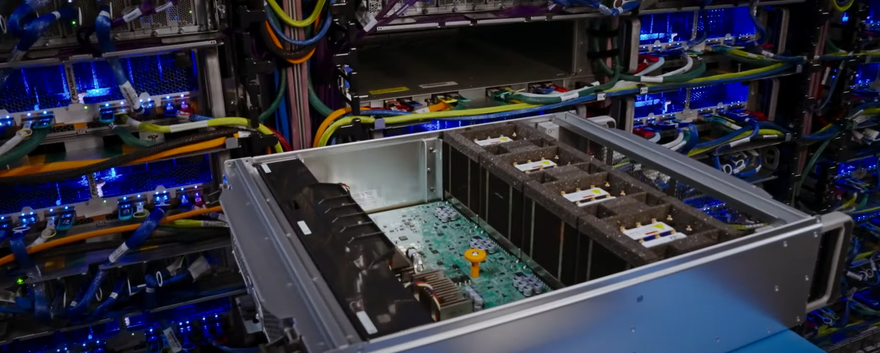

Uma parte fundamental da ambição de IA do Google é seu conceito de hipercomputador. Anunciado no final de 2023, o hipercomputador é descrito como uma arquitetura unificada que combina e otimiza todos os elementos da pilha de software e hardware.

"Pensamos nisso como uma arquitetura de como construímos toda a infraestrutura otimizada para IA com todos os componentes", diz ele.

Esse conceito holístico vai desde os sistemas elétricos e de resfriamento dos data centers físicos até o armazenamento, rede e hardware de TI, até a pilha de software, incluindo diferentes serviços e balanceamento de carga.

"Como você obtém o máximo benefício para os clientes dessa infraestrutura da maneira mais econômica? Cada um desses componentes é importante".

Esses ganhos combinados, diz ele, significam que o Google acha que pode obter cerca de quatro vezes o desempenho de uma GPU ou TPU - os chips de IA que a empresa desenvolveu internamente - em comparação com uma abordagem em silos.

Em uma época em que as empresas estão comprando dezenas de milhares de GPUs por milhões de dólares e construindo clusters em escala de gigawatts para abrigá-las e alimentá-las, essa melhoria é significativa.

Sobre a construção contínua do data center da empresa, Gupta diz que o pensamento do Google sobre a infraestrutura de IA geralmente está espalhado por três grandes grupos que consideram diferentes requisitos de latência e soberania.

"Se não diferenciar a latência e você não tiver requisitos soberanos, provavelmente é melhor para o cliente colocá-lo em alguns locais do mundo, e você pode usar qualquer um de nossos clusters maiores para fazer isso", diz ele.

"Há também muitos países em que você pode treinar o modelo em dados gerais em qualquer lugar. Mas para servir ao modelo, ou ajustar o modelo com seus próprios dados, ele deve estar em seu país. Para isso, analisamos quais países têm essas necessidades e como colocamos GPUs e TPUs no país para oferecer suporte aos clientes".

"A terceira maneira de pensar sobre isso é o requisito de latência, onde agora eu preciso estar, onde quer que meus clientes finais estejam. Haverá casos de uso exclusivos em que preciso de latência de milissegundos de um dígito e preciso estar muito mais perto do usuário final. Mas acho que os casos de uso sensíveis à latência estão [no] estágio inicial".

Para os dois primeiros requisitos – grandes clusters e requisitos no país – Gupta diz que a presença atual e planejada da empresa na região é suficiente. Para os requisitos de baixa latência e soberania mais rígidos, a empresa busca oferecer soluções em nuvem no local.

Trazendo a IA para a nuvem local

A maioria dos principais fornecedores de nuvem já tentou convencer as grandes empresas de que deveriam mover todas as cargas de trabalho para a nuvem.

Foi interessante, no entanto, na cúpula do Google Cloud em Londres, ver um slide alegando que o setor agora "passou do último ciclo de atualizações de data center corporativo" e que mesmo as grandes empresas não estavam mais apenas "em primeiro lugar", mas visando "apenas a nuvem", embora várias manchetes sobre a repatriação da nuvem possam sugerir o contrário.

Gupta é mais comedido com a ideia da morte dos data centers corporativos.

"Para a IA, tenho que fazer algo novo. Mas que novo caminho eu tomo?" ele diz. "Se você deseja o máximo de aumento e redução, o máximo de flexibilidade, a inovação mais recente entregue e essas economias de escala, a nuvem pública é o melhor lugar para fazer isso”.

"Mas eu trabalho com muitos clientes onde isso simplesmente não vai funcionar. Se algo o mantém no local, queremos garantir que você obtenha a mesma experiência de nuvem e possa obter IA em qualquer lugar que precisar", acrescenta.

"Defesa, governo federal, indústrias altamente regulamentadas, bancos centrais, setor de energia; existem muitos casos de uso em que eles simplesmente não estão prontos ou não podem aproveitar a nuvem pública para algumas de suas cargas de trabalho e dados".

O Google Distributed Cloud é a resposta da empresa para trazer recursos e modelos de consumo semelhantes aos da nuvem para os locais on-premise e Edge dos clientes. Assim como a Amazon Web Services (AWS), o Microsoft Azure e até mesmo o Oracle Cloud, o Google oferece servidores e racks locais pré-configurados e gerenciados que os clientes podem colocar em seus próprios data centers e outros locais de Edge, que oferecem acesso aos serviços de nuvem do Google.

Ele usa hardware de terceiros de empresas como HPE ou Dell, em vez de seus próprios servidores proprietários.

A versão conectada do serviço começa em um servidor 1U, escalável para centenas de racks. A oferta air-gap começa como um pequeno eletrodoméstico e também pode ser dimensionada para centenas de racks.

Um cliente notável é o McDonald's, que está colocando o hardware do Google Distributed Cloud em milhares de suas lojas em todo o mundo para analisar equipamentos. Várias empresas estão usando o serviço para oferecer sua própria nuvem soberana aos clientes.

Para clientes que desejam recursos de IA no local, mas desejam uma experiência semelhante à nuvem – e modelo de custo – sem a necessidade de investir em GPUs, as ofertas de nuvem no local dos hiperescalas podem ser uma opção viável, potencialmente oferecendo menor latência e custos.

Os casos de uso baseados em IA que o Google está vendo para clientes locais incluem tradução em execução, modelos de fala para texto, recursos de pesquisa corporativa e inferência local.

"Às vezes, ouvimos que os clientes não têm problema em treinar seu modelo na nuvem pública, mas depois querem trazê-lo para o local, ajustá-lo e criar seu próprio agente ou qualquer aplicativo que estejam tentando criar", diz Gupta.

A modernização de aplicações – refatorando e atualizando aplicativos corporativos existentes enquanto tenta criar novos recursos de IA – é outro fator para esses tipos de implementações locais.

"Ao lado dessa aplicação e agente de IA, ainda há uma tonelada de aplicativos e dados corporativos em muitos locais diferentes, muitos deles em VMs, no local", diz Gupta. "À medida que as empresas analisam a decisão de investimento em IA, quanto do restante desse patrimônio também vai para um novo modelo de nuvem? Isso pode ajudar você a migrar esses ambientes locais para outro ambiente local que seja um ambiente de nuvem com APIs de nuvem".

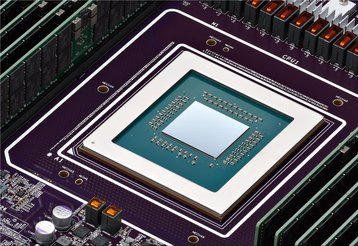

Por enquanto, Gupta diz que a oferta de nuvem distribuída fornece apenas GPUs Nvidia; atualmente, os clientes não conseguem obter acesso aos TPUs de última geração do Google fora dos data centers do Google - embora ofereça uma mini versão conhecida como Edge TPU em uma placa de desenvolvimento por meio de sua subsidiária Coral.

O Google não está sozinho nisso; nem a Microsoft nem a Amazon oferecem seu silício personalizado como parte de seus serviços locais. Quando perguntado se os TPUs do Google poderiam chegar aos locais dos clientes por meio de sua nuvem distribuída, Gupta diz que a empresa está aberta à ideia.

"Poderíamos evoluir isso para AMD ou Intel, ou para oferecer suporte aos nossos próprios servidores com TPUs? Sim. Mas agora, para os casos de uso que estamos vendo até agora, sentimos que os cobrimos com o A100 e o H100 da Nvidia, e procuraremos oferecer suporte ao H200 também".

Ele acrescenta: "Continuaremos a olhar para esse mercado e, se precisarmos oferecer suporte a hardware diferente, é claro, com certeza evoluiremos".

Soberania – o verdadeiro impulsionador do investimento em IA?

O Google, como seus pares de nuvem pública, está investindo pesadamente em mercados existentes, como o Reino Unido, onde a empresa anunciou um novo data center de 1 bilhão de dólares (5,6 bilhões de reais) no início do ano.

Em meio a uma grande crise de capacidade em muitos mercados estabelecidos, especialmente na Europa, a DCD pergunta se a soberania estava levando a empresa a investir em novas instalações focadas em IA nesses mercados desafiadores. Gupta diz que é "100 por cento" o caso.

"Varia dependendo do caso de uso que você precisa colocar", diz ele. "A quantidade de infraestrutura e a infraestrutura que você coloca realmente depende dos casos de uso que você está tentando atender no país”.

"Existem clientes que têm requisitos de soberania que exigem que os dados permaneçam no país. Eles devem fazer inferências no país. E, portanto, precisamos ver como aumentamos e aumentamos nossa infraestrutura para dar suporte a isso".

Descrevendo isso como "um continuum de soberania", ele continua: "Construímos data centers de todos os tipos, todos os tamanhos diferentes, e colocaremos a infraestrutura certa com base nas necessidades do mercado; podem ser TPUs, GPUs. Podem ser CPUs".

Depois de ser o lugar onde a genAI começou e ver seus concorrentes conquistarem grande parte do mercado, o Google agora espera que esse continuum finalmente permita que ele se torne o lar da IA.