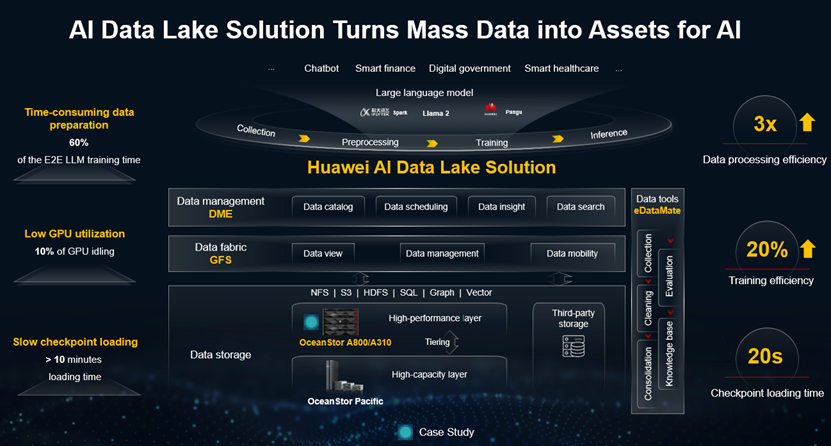

No Mobile World Congress (MWC) desse ano em Barcelona, Espanha, a gigante chinesa de TIC Huawei anunciou sua solução AI Data Lake, que descreve como uma de suas "soluções destinadas a ajudar empresas em todo o mundo a construir infraestrutura de dados líder na era da IA".

Há uma série de desafios que devem ser superados ao melhorar a qualidade do modelo de IA.

Em primeiro lugar, a preparação de dados é um gargalo, normalmente respondendo por 60% do tempo de treinamento do modelo de ponta a ponta. Duas razões que dificultam a preparação de dados de alta qualidade incluem acesso a dados diversificados e dados brutos em escala EB de conjuntos de amostras. São ossos duros de roer no treinamento de modelos.

As GPUs são o componente mais crítico para esse tipo de treinamento, pois melhorar a utilização da GPU normalmente se correlaciona com reduções significativas de custos. No treinamento de modelos, a latência de armazenamento geralmente causa tempo ocioso da GPU, que representa até 10% do tempo total de execução da GPU.

Um processo complexo que pode se estender por vários meses em certos casos, é agravado por interrupções causadas por baixa eficiência de computação em cluster, falhas frequentes e solução de problemas lenta. Essas dores de cabeça tornam o treinamento do modelo incapaz de ser retomado rapidamente, reduzem as taxas de sucesso e aumentam os custos de treinamento. Para evitar o impacto do tempo de inatividade e falhas, os pontos de verificação são usados periodicamente para registrar e, posteriormente, carregar os resultados do treinamento. Mesmo com essa proteção, o carregamento pode levar bem mais de dez minutos, o que é inadequado para o treinamento de LLM (modelo de linguagem grande).

A DCD conversou com Michael Qiu, presidente do departamento de armazenamento de dados, marketing global e vendas de soluções da Huawei, para saber mais sobre o que está em oferta. Começamos perguntando a Qiu sobre a escolha de se referir a uma solução "AI Data Lake" quando a oferta se estende à funcionalidade Data Warehouse e Data Lakehouse.

Ele nos disse: "DataLake/LakeHouse são conceitos da era do Big Data. A maioria dessas soluções faz parte de uma construção com software pronto para uso e hardware de uso geral, mas à medida que entramos na era AI/LLM, precisamos de uma infraestrutura de dados pronta para IA para suportar cargas de trabalho mistas de Big Data e IA, em que a infraestrutura de dados desempenha um papel importante. É por isso que planejamos a solução e a chamamos de "AI Data Lake", incluindo inovações na camada de software e hardware".

Visível, gerenciável, disponível

A solução "AI Data Lake" da Huawei visa garantir dados visíveis, gerenciáveis e disponíveis, transformando dados em massa em ativos valiosos e acelerando todo o processo de serviço de IA. Veja como funciona:

Um pool de recursos unificado de armazenamento de Data Lake é equipado com uma camada de alto desempenho e uma camada de alta capacidade, esta última pode ser expandida de forma flexível para armazenar dados em massa. A camada de alto desempenho fornece 100 milhões de IOPS e 10 terabytes por segundo de largura de banda, melhorando a eficiência do treinamento de LLM.

Um recurso inteligente de camadas de dados é usado para armazenar os dados quentes, mornos e frios nas camadas de armazenamento apropriadas e garantir o custo total de propriedade ou TCO ideal.

A malha de dados é usada para coletar dados em massa com eficiência entre fornecedores, regiões e sistemas, alcançando mobilidade de dados segura e sob demanda. Uma rede de ferramentas de dados é fornecida para implementar uma conversão automática completa de dados em conhecimento. Esse processo envolve limpeza e aprimoramento de dados, como a geração automática de pares de controle de qualidade de alta qualidade e a conversão automática de dados em uma base de conhecimento vetorial.

Tudo isso vem junto com uma plataforma de gerenciamento de dados para implementar gerenciamento e controle global de ativos de dados, incluindo listas globais de ativos de dados, coleta e análise de dados e gerenciamento de compartilhamento de dados.

A vantagem da IA

Qiu explica algumas das inovações que a inteligência artificial "incorporada" pode trazer para a eficiência das cargas de trabalho de IA:

"Os produtos da série OceanStor A são um design dedicado a cargas de trabalho de IA por vários motivos. Eles oferecem desempenho extremamente alto para modelos de E/S mistos porque, durante processos de IA, como coleta de dados, limpeza, treinamento e interferência, o armazenamento deve fornecer alta largura de banda para arquivos grandes (ponto de verificação, vídeos, imagens grandes) e alto IOPS para arquivos pequenos (texto, imagens, áudio), a TI também requer diferentes comportamentos de E/S, incluindo leitura/gravação sequencial e leitura/gravação aleatória, o que é bem diferente em comparação com os requisitos para o processamento de big Data".

Ele enfatiza: "Os recursos de expansão em nível de EB com acesso a um único namespace e clusters de treinamento LLM têm inserido trilhões de parâmetros e exigem o nível de EB dos dados originais coletados. Se construirmos uma infraestrutura de dados de IA em várias regiões, mover dados entre diferentes clusters de armazenamento custará mais de 60% de todo o processo de treinamento de IA. Além disso, o acesso a um único namespace pode facilitar o fluxo de trabalho de IA de camada superior, sem a necessidade de gerenciar a distribuição de dados no armazenamento".

Além desses dois pontos, a solução integra a base de conhecimento Vector e oferece suporte a vários sistemas de arquivos, incluindo NFS, S3 e Parallel ao mesmo tempo.

OceanStor no núcleo de armazenamento

No centro da oferta da Huawei está o OceanStor A800, um novo tipo de armazenamento que oferece velocidades incrivelmente rápidas. Com uma arquitetura inovadora de separação de dados e plano de controle, o OceanStor A800 permite que os dados sejam transferidos diretamente dos módulos de interface para os discos, contornando os gargalos criados por CPUs e memória.

Isso significa que o OceanStor A800 pode oferecer desempenho 10 vezes maior do que o armazenamento tradicional e 24 milhões de IOPS por gabinete do controlador. Além disso, o carregamento do conjunto de treinamento é quatro vezes mais rápido do que os concorrentes mais próximos.

O inovador sistema de arquivos paralelo de alto desempenho OceanFS permite que o OceanStor A800 atinja uma largura de banda de 500 GB/s por gabinete de controlador. Isso significa que, ao treinar um modelo de trilhões de parâmetros, uma leitura de ponto de verificação de nível de 5 TB pode ser concluída em apenas 10 segundos, e o treinamento pode ser retomado a partir de pontos de verificação, neste caso, três vezes mais rápido do que seu concorrente mais próximo.

O OceanStor A800 suporta expansão flexível para formar um hipercluster. Ele pode escalar horizontalmente para 512 controladores e suporta capacidade de nível EB para clusters LLM com trilhões – até mesmo ultrapassando dez trilhões – parâmetros. Ele também pode oferecer suporte a recursos como malha de dados incorporada, mecanismo vetorial e resiliência de dados. Esses recursos podem ser carregados com base nos requisitos do cliente.

A sustentabilidade é importante

Finalmente, com a sustentabilidade na boca de todos, queríamos explorar as credenciais de consumo de energia da solução de Data Center de IA da Huawei. Qiu explica: "A eficiência energética é um fator importante para a infraestrutura de IA e nosso produto atende bem a esse requisito”.

"Adotamos maior desempenho e densidade de capacidade em nossas soluções de Data lake de IA, como 1 TB/Watts (a energia usada para ler/gravar 1 TB de dados em 1s custa apenas 1 joule), 500 GB/s e 24 milhões de IOPS por espaço de 8U para nosso nível de desempenho, 64 discos em nosso espaço de 8U para nosso nível de capacidade. Isso é reforçado pelo fato de que o uso de nossa solução pode reduzir o espaço ocupado, ajudando os clientes a reduzir drasticamente o espaço em rack e os requisitos de resfriamento relacionados".

A solução Huawei AI Data Lake realiza a coleta eficiente de dados em massa diversificados de vários fornecedores, regiões e sistemas, usando malha de dados. A mobilidade de dados sob demanda e segura é complementada por dados globalmente visíveis e gerenciáveis, para alcançar uma eficiência de agendamento de dados entre domínios três vezes maior.

A solução também fornece até 500 GB/s e 24 milhões de IOPS para treinamento de LLM que sobrecarrega a gravação, a recuperação e o carregamento inicial do ponto de verificação. Reduz o tempo ocioso da GPU enquanto melhora a utilização da GPU, combinando-se para melhorar a eficiência do treinamento em 20% em média.

Para obter mais informações sobre o Huawei Data Storage, clique aqui.